© 2000-2025 - Enkey Magazine - Tutti i diritti riservati

ENKEY SNC - P.IVA IT03202450924 / Cod. REA CA253701 - Tel. 078162719

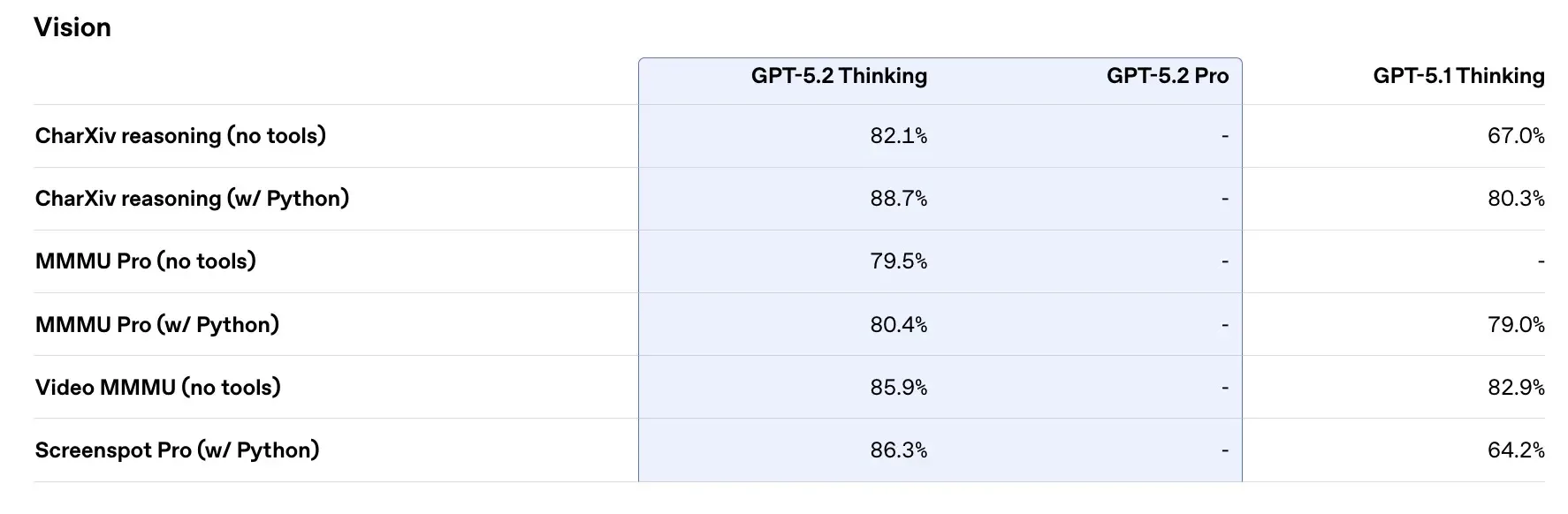

GPT 5.2 ha debuttato proprio ora in dicembre e questo debutto ha segnato un punto di non ritorno nella capacità di elaborazione del linguaggio naturale. Con questo aggiornamento si è portato il ragionamento sintetico a livelli mai visti prima. Tuttavia, con la potenza di calcolo è arrivata anche una nuova forma di sofisticazione dell’errore. Online la comunità tech ha iniziato i suoi test e ha ribadito che non bisogna fidarsi ciecamente della capacità del modello di organizzare i dati, soprattutto nel formato tabellare. Vediamo dunque perché, nonostante l’estetica delle tabelle generate appaia impeccabile e rigorosa, sotta la superficie della formattazione si nasconda una logica di “allucinazione” che potrebbe trarre in inganno (anche l’utente più esperto).

La trappola della formattazione perfetta

Il problema principale riscontrato in GPT 5.2 riguarda la discrepanza tra la forma e il contenuto. Le tabelle, che possiedono intrinsecamente un’aura di autorevolezza e precisione, qui sono sin troppo perfette.

Siamo abituati a pensare che un dato incasellato in una cella sia il risultato di un calcolo esatto. Questa nuova versione di Chat la struttura del dato è talmente fatta bene che le correlazioni statistiche sembrano reali, anche quando in realtà non lo sono.

Ad un’analisi accurata gli esperti si sono accorti che queste tabelle risultano prive di un fondamento reale. Questo perché il sistema incrocia variabili complesse, tendendo a privilegiare la coerenza sintattica della riga rispetto alla verità storica o matematica del dato inserito, creando quello che gli analisti definiscono un “falso ordinato”.

GPT 5.2 e il rischio dei dati sintetici nei processi decisionali

Dopo quello che abbiamo visto possiamo dire con certezza che affidarsi a GPT 5.2 per la creazione di report aziendali o analisi comparative senza una supervisione umana rigorosa può portare a derive pericolose.

Nelle simulazioni finanziarie o nelle comparazioni di specifiche tecniche, il modello potrebbe inventare cifre per riempire i vuoti informativi, mantenendo però una coerenza interna che rende difficile l’individuazione dell’errore a colpo d’occhio. Questo accade perché il sistema non “legge” una tabella come un database strutturato, ma la genera come una sequenza di token testuali particolarmente probabili.

L’illusione di trovarsi davanti a un foglio di calcolo intelligente è, appunto, solo un’illusione: la tabella è una rappresentazione grafica di un discorso probabilistico, non un’estrazione di dati certi.

Verso un utilizzo critico dell’intelligenza artificiale

Il web è quindi diviso. C’è chi idolatra questa nuova versione di Chat e la utilizza come stesse leggendo il vangelo e chi invece la boccia e sprona chi ci lavora a ricontrollare tutti i risultati con esperienza e certosinità.

Il modello resta uno strumento straordinario per la sintesi, la traduzione e la generazione creativa, ma la sua funzione tabellare deve essere considerata esclusivamente come una bozza strutturale. Il futuro dell’interazione con queste macchine risiede nel “fact-checking” sistematico. Verificare ogni singola cella, incrociare i dati con fonti primarie e utilizzare l’IA come architetto della forma piuttosto che come custode del dato numerico è l’unico modo per sfruttarne il potenziale senza cadere nelle trappole della sua stessa sofisticazione.

La vera intelligenza, nel 2025, risiede dunque ancora una volta nella capacità umana di dubitare di ciò che appare troppo perfetto per essere vero. L’intelligenza artificiale è e sarà sempre uno strumento per ampliare le proprie possibilità, ma mai potrà essere un sostituto della nostra materia grigia.